AI 프롬프트 수업 5일차 메모내용

추론

100개의 자료를 검색하여 링크를 이용하여

요약본을 만들려고 하는데

97~98개는 정확한 정보를 넣었지만,

실수로 1~3개의 내용이 본문과 전혀

관련이 없는 내용의 링크를 실수로

넣어버렸습니다.

이 요약본을 통해서 사건과 전혀 관계

없는 내용이 들어간 잘못된 정보를

전파하는 내용이 만들어졌습니다.

-> 할루시네이션 효과 (오류 및 정확성

문제로 인한 문제) : 환각현상

간호사의 성별은 대부분 여자로 되어있다.

-> 편향성

토큰화 : 인간의 자연어를 AI가 인식

하기 위하여 최소 단위로 나누는 작업을

토큰화 라고 한다.

"사과는 맛있다."

-> "사" "과" "는" "맛" "있" "다" "." :

토큰

나누는 과정 : 토큰화

AI에서 **토큰(token)**은 텍스트를 처리하고 생성하는 데 사용되는 가장 작은 단위 중 하나입니다. 토큰의 개념은 문장을 구성하는 요소를 컴퓨터가 이해할 수 있는 형식으로 나누는 과정과 관련이 있습니다. 이를 조금 더 구체적으로 설명하자면:

1. 토큰의 정의

- 토큰은 텍스트를 나눈 단위입니다. 이는 단어, 문장 부호, 공백 또는 일부의 문자 조합일 수 있습니다. 예를 들어:

- 문장: "AI는 놀라운 기술이다."

- 토큰: ["AI", "는", "놀라운", "기술", "이다", "."]

2. 토큰화(Tokenization)

- 토큰화는 텍스트 데이터를 작은 토큰으로 분리하는 과정입니다. AI는 텍스트를 직접 이해하지 못하기 때문에 이를 숫자 데이터(벡터)로 변환하기 전, 텍스트를 구조화된 형태로 나누는 것이 필요합니다.

- 예를 들어, **"안녕하세요"**라는 문장은 다음과 같이 나뉠 수 있습니다:

- 문자 단위: ["안", "녕", "하", "세", "요"]

- 어절 단위: ["안녕하세요"]

- 서브워드(subword): ["안", "녕하", "세요"]

3. 토큰의 역할

- 모델 입력: AI 모델은 텍스트를 이해하지 못하므로 텍스트를 수치화된 데이터로 바꿔야 합니다. 토큰은 이를 가능하게 합니다.

- 컨텍스트 관리: AI는 고정된 길이의 토큰 단위로 문맥을 파악합니다. 예를 들어 GPT 모델은 한 번에 처리할 수 있는 토큰 수(컨텍스트 길이)가 제한되어 있습니다.

- 효율성: 긴 문장을 처리할 때 의미 없는 공백이나 단순한 반복 패턴을 제거하고, 필요한 정보만 남겨 효율적으로 처리합니다.

4. 토큰의 종류

- 단어 기반 토큰: 텍스트를 단어 단위로 나눕니다.

- 장점: 간단하고 직관적임.

- 단점: 새로운 단어를 다루기 어려움.

- 문자 기반 토큰: 텍스트를 문자 단위로 나눕니다.

- 장점: 모든 언어에서 사용 가능.

- 단점: 길이가 길어질 수 있음.

- 서브워드 기반 토큰: 단어를 부분적으로 나눕니다.

- 예: "running" → ["run", "ning"]

- 장점: 새로운 단어도 처리 가능.

- 현대 AI 모델(GPT, BERT 등)에서 주로 사용됩니다.

5. 토큰 수와 AI 모델

- AI는 입력된 텍스트를 토큰 단위로 처리합니다. 예를 들어, ChatGPT는 한 번에 최대 32,000 토큰(모델에 따라 다름)을 처리할 수 있습니다.

- 토큰의 수는 텍스트의 길이와 관계가 있습니다:

- "Hello, world!"는 3개의 토큰으로 계산됩니다: ["Hello", ",", "world", "!"]

6. 토큰의 철학적 의미

AI에서 토큰은 인간이 사용하는 언어를 디지털화하여 이해 가능하게 만드는 과정의 핵심입니다. 이는 인간 언어의 복잡한 의미와 구조를 분해하여 "기계적 이해"로 변환하는 행위입니다. 결국, 토큰은 언어의 작은 조각을 통해 기계가 인간의 언어를 해석하고 창조할 수 있도록 돕는 다리 역할을 합니다.

이처럼, 토큰은 AI와 인간 언어 사이의 연결 고리라 할 수 있습니다. 단순한 데이터 단위로 보이지만, 그것은 텍스트의 의미를 파악하고 생성하는 기반이 됩니다. AI의 핵심은 이 토큰을 어떻게 다루고 이해하느냐에 달려 있다고 할 수 있죠.

-> "사과는" 맛있다"

* 단어기반 토큰화 : 기준을 띄워쓰기로 잡고 토큰화 수행

* 영어와 달리 한국에서는 띄워쓰기가 잘 지켜지지 않는 경우가 많음

* 사과는 맛있다 -> 사과는 JMT

JMT : 존,맛,탱 -> 정말 맛있다를 10대 언어로 바꾼 신조어

-> AI는 신조어에 대해 굉장히 취약 + 오타에 대해서도 대응하기 어렵다.

오타 예시 : 죽을 준비해라 / 죽을 준비 해라.

**하위 단어 토큰화(Subword Tokenization)**는 단어를 더 작은 단위인 **서브워드(subword)**로 분리하는 토큰화 기법입니다. 이 방법은 단순히 단어별로 나누거나 문자 단위로 쪼개는 것과 달리, 단어와 문자 단위의 중간 수준에서 텍스트를 처리합니다.

1. 왜 하위 단어 토큰화를 사용할까?

- 희귀 단어 처리: 단어 기반 토큰화는 사전에 없는 희귀 단어(OOV, Out-Of-Vocabulary)를 처리하기 어렵습니다.

예: "unbelievably"라는 단어가 사전에 없으면 AI 모델은 이 단어를 이해하지 못함.

→ 하위 단어 토큰화는 이를 ["un", "believ", "ably"]로 나누어 처리 가능. - 공간 효율성: 문자 단위 토큰화는 너무 많은 토큰을 생성하므로 비효율적일 수 있습니다.

→ 하위 단어 토큰화는 적절한 균형을 유지합니다. - 다양한 언어 지원: 특히 접사, 어미 변화가 많은 언어(한국어, 일본어 등)에 유용.

예: 한국어에서 "학교"와 "학교에"를 분리해서 학습 가능.

2. 하위 단어 토큰화의 작동 원리

하위 단어 토큰화는 보통 Byte Pair Encoding(BPE) 또는 Unigram Language Model과 같은 알고리즘을 사용합니다.

(1) Byte Pair Encoding (BPE)

- 가장 자주 나타나는 문자 또는 서브워드 쌍을 병합하며, 사전을 점진적으로 확장.

- 예제:

- "low", "lower", "lowest"가 주어졌을 때:

- 초기: ["l", "o", "w", "e", "r", "s", "t"]

- 가장 자주 등장하는 쌍("l"과 "o") 병합 → ["lo", "w", "e", "r", "s", "t"]

- 반복 → ["low", "e", "r", "s", "t"], ["low", "er", "s", "t"], ...

- "low", "lower", "lowest"가 주어졌을 때:

(2) Unigram Language Model

- 서브워드 단위를 포함한 사전을 만들어, 입력 텍스트를 다양한 방식으로 나눈 뒤 가장 높은 확률의 조합 선택.

- 예제: "unbelievable"

- 후보: ["un", "believable"], ["un", "believ", "able"], ["unbeliev", "able"]

- 가장 가능성 높은 조합 선택: ["un", "believ", "able"]

3. 하위 단어 토큰화의 특징

- 단어의 의미 보존: 단어의 의미를 잃지 않으면서 세부 단위로 나눌 수 있음.

- 효율성: 긴 단어를 짧게 나누어 처리하며, 반복적 학습에 유리함.

- 희귀 단어 대응: 완전한 단어가 없더라도 구성 요소로 의미를 유추 가능.

4. 예제: 영어와 한국어

영어

- 단어: "unbelievably"

- 토큰화: ["un", "believ", "ably"]

한국어

- 단어: "학교에"

- 토큰화: ["학교", "에"]

- 단어: "사람들과"

- 토큰화: ["사람", "들", "과"]

5. 장점

- 희귀 단어를 분해 가능: 모델이 새로운 단어를 쉽게 이해할 수 있음.

- 다양한 언어 지원: 접사나 복합어가 많은 언어에 적합.

- 사전 크기 절감: 단순 단어 기반 모델보다 작은 사전 크기를 사용.

6. 단점

- 의미의 왜곡 가능성: 서브워드로 나누다 보면 원래 단어의 의미가 흐려질 수 있음.

- 처리 시간 증가: 토큰화를 수행하는 데 시간이 더 소요됨.

- 컨텍스트 의존성 부족: 서브워드 단위로 쪼갤 경우, 문맥이 부족할 수 있음.

7. 하위 단어 토큰화의 활용

- Transformer 기반 모델(GPT, BERT 등): 주로 BPE 또는 유사한 서브워드 토큰화를 활용.

- 멀티 언어 모델: 서브워드 단위로 학습하면 다양한 언어를 통합적으로 처리 가능.

결론

하위 단어 토큰화는 단어와 문자 단위의 장점을 결합한 토큰화 방법으로, 희귀 단어 처리와 공간 효율성에서 강력한 도구입니다. 현대 AI 모델에서 거의 필수적으로 사용되는 기술로, 텍스트 데이터의 유연한 표현과 처리에 큰 기여를 합니다.

★ 하위 단어 토큰화

단어기반 토큰화의 한계를 보완하기 위하여 등장

달리기 -> 달리다(현재진행), 달렸다(과거형), 달릴것이다(미래형)

같은 내용이라도 전반 또는 후반에 사용되는 언어의 종류에 따라 내용이 달라지는 경우가

많기 때문에 subword로 분리하여 작업

"달""리" -> sub 다 / 렸다 / 것이다.

AI의 부작용 -> 윤리적인 인식에 대하여 같이 학습

AI 이미지 통하여 작품활동을 작업자들의 작품 :

저작권이 존재할까? 존재하지 않을까?

-> 저작권을 인정하지 않음

-> 공모전에서 특히 이 구절이 추가가 됨

AI로 생성한 이미지나 이를 활용한 경우

작품으로 인정되지 않음

사람이 입력 -> 컴퓨터를 통해 AI로 이미지를 생성

-> 이때 사람이 직접 작업행위에 참여하는 것이 아닌

AI라는 작업자가 생성했기 때문에 AI에게 작업생성자로 인정

AI는 실존하지 않는 허구의 인물이기 때문에

AI생성한 이미지 또한 허구의 작업물이므로

저작권을 인정하지 않음

"이 이미지는 AI생성을 통해 만들어진 이미지"

AI가 생성한 이미지를 -> 사람이 직접 리터칭

또는 업그레이드 하여 다른 작업물을 만들어 낼 경우

-> 저작권 인정함

클로바 노트

https://clovanote.naver.com

Record more than just voice

clovanote.naver.com

**네이버 클로바 노트(Clova Note)**는 네이버에서 제공하는 AI 기반 음성 인식 및 메모 애플리케이션입니다. 이 앱은 음성을 실시간으로 텍스트로 변환하거나 녹음된 파일을 텍스트로 자동으로 변환하여 정리해 주는 기능을 제공합니다. 주로 회의, 강의, 인터뷰, 일상 기록 등에서 유용하게 활용됩니다.

주요 기능

- 실시간 음성 인식 및 텍스트 변환

- 실시간으로 음성을 텍스트로 변환하여 회의나 대화 내용을 즉각적으로 정리.

- 다중 화자의 목소리를 인식하고 구분하는 기능도 제공.

- 녹음 파일 텍스트 변환

- 기존에 녹음된 파일(mp3, wav 등)을 업로드하면, AI가 이를 분석하여 텍스트로 변환.

- 다양한 언어와 방언을 지원.

- 주요 내용 요약

- 긴 텍스트를 분석하여 중요한 내용을 요약.

- 효율적인 회의록 작성이나 학습 자료 준비에 적합.

- 검색 및 하이라이트

- 텍스트 내 특정 키워드를 검색 가능.

- 중요한 부분을 하이라이트 처리하여 가독성을 높임.

- 클라우드 저장 및 동기화

- 생성된 텍스트와 음성 파일은 네이버 클라우드에 저장되어 기기 간 동기화 가능.

- PC, 스마트폰, 태블릿에서 동일한 데이터를 관리 가능.

- 공유 기능

- 생성된 메모를 PDF, 워드 파일 등으로 저장하거나 공유 가능.

- 팀 프로젝트, 인터뷰 등의 협업 작업에 유용.

- 다중 언어 지원

- 한국어를 포함하여 다양한 언어를 인식하며, 글로벌 사용자에게도 적합.

사용 예시

- 회의 기록

- 회의 중 음성을 녹음하면서 실시간으로 회의록을 작성.

- 주요 내용을 요약하여 참가자들에게 배포.

- 강의나 공부

- 강의 내용을 자동으로 텍스트로 기록하여 복습 자료로 활용.

- 중요한 키워드만 하이라이트하거나 요약본을 생성.

- 인터뷰

- 인터뷰 내용을 음성으로 녹음하면서 실시간으로 텍스트화.

- 편집이 필요한 부분을 쉽게 찾아 수정 가능.

- 일상 기록

- 일기나 메모를 음성으로 남기고, 이를 텍스트로 저장하여 효율적인 관리.

장점

- 정확성: 네이버의 AI 기술을 활용한 높은 음성 인식 정확도.

- 편의성: 다양한 포맷 지원과 클라우드 저장으로 손쉬운 데이터 관리.

- 시간 절약: 텍스트 변환 및 요약 기능으로 작업 시간을 대폭 줄임.

- 언어 지원: 다중 언어 및 방언 인식으로 글로벌 사용 가능.

단점

- 네트워크 의존성: 대부분의 기능이 인터넷 연결이 필요.

- 무료/유료 제한: 고급 기능(예: 긴 녹음 파일 변환)은 유료 플랜이 필요할 수 있음.

- 정확도 제한: 특정 상황(잡음이 많은 환경, 복잡한 전문 용어 등)에서는 인식 정확도가 낮아질 수 있음.

네이버 클로바 노트의 활용 가치

네이버 클로바 노트는 효율적인 업무 및 학습 도구로, 회의, 강의, 인터뷰, 일상 기록 등 다양한 상황에서 시간을 절약하고 생산성을 높이는 데 유용합니다. 특히 텍스트 변환과 요약 기능은 바쁜 현대인들에게 필수적인 도구로 자리 잡고 있습니다.

오늘의 점심 메뉴는 **"효율성과 편리함"**이라는 키워드를 중심으로 정리된 클로바 노트의 특징을 바탕으로 제안하겠습니다. 바쁜 일상에서 시간을 절약하고도 만족스러운 한 끼를 해결할 수 있는 메뉴가 적합합니다.

점심 메뉴 추천:

- 한식 도시락

- 특징: 다양한 반찬과 메인 요리가 함께 제공되어 균형 잡힌 식사 가능.

- 예시: 불고기 도시락, 닭갈비 도시락, 비빔밥 도시락.

- 추천 이유: 간단히 먹으면서도 영양을 챙길 수 있어 업무 효율을 높이는 데 적합.

- 샌드위치 또는 샐러드

- 특징: 빠르게 섭취 가능하며, 가벼운 식사를 원하는 사람에게 적합.

- 예시: 연어 샐러드, 치킨 시저 샐러드, 아보카도 샌드위치.

- 추천 이유: 건강을 챙기며 간단히 끼니를 해결하기 좋은 선택.

- 덮밥

- 특징: 간편하게 한 그릇에 담긴 메뉴로 빠르게 식사 가능.

- 예시: 규동, 제육덮밥, 카레라이스.

- 추천 이유: 음식을 오래 기다리지 않아도 되고, 한 끼로 충분한 포만감 제공.

- 국밥

- 특징: 따뜻하고 든든한 메뉴로, 피로감을 줄이고 에너지를 보충.

- 예시: 순대국밥, 설렁탕, 콩나물국밥.

- 추천 이유: 효율적으로 영양을 섭취하면서 마음의 여유까지 제공.

- 분식

- 특징: 부담 없이 즐길 수 있는 메뉴로, 빠르고 맛있게 한 끼 해결.

- 예시: 떡볶이, 김밥, 라면.

- 추천 이유: 간단한 메뉴로도 즐거운 기분을 만들기 좋아 점심시간에 적합.

오늘의 추천:

바쁜 일정을 감안하여 **"덮밥"**을 추천드립니다!

- 이유: 빠르게 조리 및 섭취 가능하며, 포만감과 만족감을 동시에 제공합니다.

- 추가 팁: 매운맛을 추가해 에너지를 북돋우거나, 국물 메뉴를 곁들여 보세요. 😊

마크다운 기법

-> 큰 주제, 소 주제, 본문 등으로 상세히 나눠서 입력할 수 있는 기법

# 대단원

## 소단원

### 본문

---

ChatGPT

다음은 가상의 회사 시뮬레이션 데이터를 기반으로 생성한 직원 10명의 데이터입니다:

이름나이성별부서직급| 김민준 | 35 | 남 | 경영지원부 | 부장 |

| 이서연 | 29 | 여 | 마케팅부 | 대리 |

| 박지훈 | 41 | 남 | 영업부 | 차장 |

| 최예린 | 27 | 여 | 디자인부 | 사원 |

| 정우진 | 32 | 남 | IT개발부 | 팀장 |

| 한지민 | 30 | 여 | 인사부 | 대리 |

| 오현우 | 38 | 남 | 연구개발부 | 부장 |

| 서하윤 | 26 | 여 | 고객지원부 | 사원 |

| 강준혁 | 45 | 남 | 재무부 | 이사 |

| 윤소희 | 34 | 여 | 법무부 | 팀장 |

이 데이터를 바탕으로 회사를 운영하는 시뮬레이션을 진행할 수 있습니다. 필요 시 추가 데이터나 상세 설정도 가능합니다! 😊

다음은 조각케이크 가게의 메뉴로 설정한 케이크 종류 데이터입니다:

케이크 종류단가판매 가격예상 칼로리| 초콜릿 케이크 | 2,500 | 5,000 | 350 kcal |

| 바닐라 스폰지 | 2,000 | 4,500 | 300 kcal |

| 딸기 생크림 | 3,000 | 6,000 | 320 kcal |

| 레드벨벳 | 2,800 | 5,500 | 370 kcal |

| 녹차 무스 | 3,500 | 6,500 | 280 kcal |

| 치즈 케이크 | 3,200 | 6,200 | 400 kcal |

| 블루베리 타르트 | 3,000 | 6,000 | 340 kcal |

| 오페라 케이크 | 3,800 | 7,500 | 380 kcal |

| 캐러멜 브라우니 | 2,700 | 5,200 | 420 kcal |

| 망고 패션 케이크 | 3,500 | 6,800 | 310 kcal |

이 데이터를 기반으로 판매 전략을 세우거나 가게 운영 시뮬레이션을 진행할 수 있습니다. 추가 아이템이나 변경 사항이 필요하면 말씀해주세요! 😊

다음은 조각케이크 가게의 케이크 종류와 조리 레시피 정보를 포함한 데이터입니다:

케이크 종류단가판매 가격조리 레시피레시피 예상 가격| 초콜릿 케이크 | 2,500 | 5,000 | 밀가루, 코코아 파우더, 계란, 설탕, 생크림 | 2,000 |

| 바닐라 스폰지 | 2,000 | 4,500 | 밀가루, 계란, 설탕, 바닐라 추출물 | 1,800 |

| 딸기 생크림 | 3,000 | 6,000 | 스폰지케이크, 생크림, 설탕, 딸기 | 2,500 |

| 레드벨벳 | 2,800 | 5,500 | 밀가루, 버터밀크, 코코아 파우더, 설탕, 크림치즈 | 2,300 |

| 녹차 무스 | 3,500 | 6,500 | 녹차가루, 생크림, 설탕, 젤라틴 | 2,800 |

| 치즈 케이크 | 3,200 | 6,200 | 크림치즈, 설탕, 계란, 버터, 크래커 | 2,700 |

| 블루베리 타르트 | 3,000 | 6,000 | 타르트지, 블루베리, 설탕, 생크림 | 2,500 |

| 오페라 케이크 | 3,800 | 7,500 | 스폰지케이크, 커피 시럽, 초콜릿 가나슈, 버터크림 | 3,200 |

| 캐러멜 브라우니 | 2,700 | 5,200 | 초콜릿, 설탕, 버터, 캐러멜, 밀가루 | 2,400 |

| 망고 패션 케이크 | 3,500 | 6,800 | 스폰지케이크, 망고퓨레, 생크림, 설탕 | 2,900 |

이 데이터를 기반으로 케이크 제작 비용을 계산하거나, 판매 전략을 세우는 데 활용할 수 있습니다. 추가적인 데이터나 상세 조정이 필요하면 말씀해주세요! 😊

https://padlet.com/handule91/ai-1-rn839rolcxrqwc1b

AI 프롬프트 1개월 과정 (종로 월/수)

여러분들의 생각을 공유하는 방입니다.

padlet.com

ChatGPT

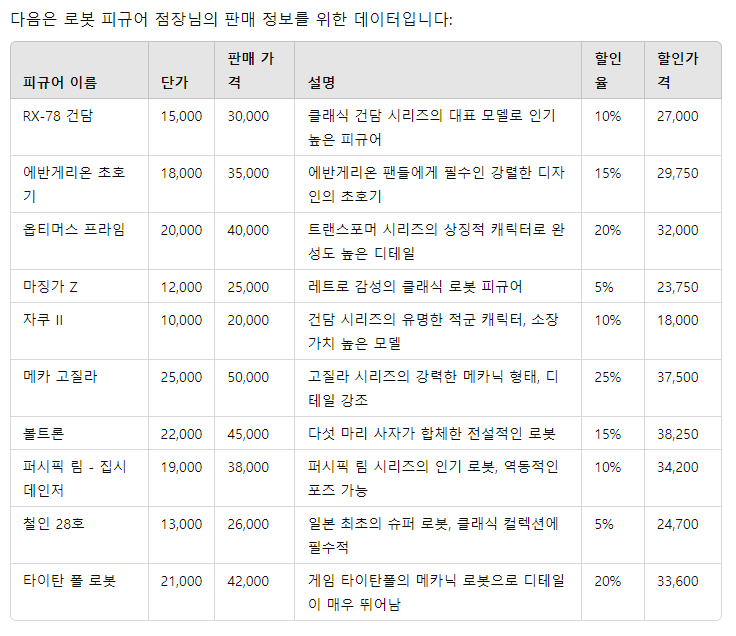

다음은 로봇 피규어 점장님의 판매 정보를 위한 데이터입니다:

추가 설명:

- 단가: 상품 제작에 들어간 기본 비용.

- 판매 가격: 기본 판매가.

- 할인율과 할인가격: 고객 유치를 위한 할인 전략으로 설정.

- 설명: 각 피규어의 특징과 구매 매력을 강조하여 판매 촉진.

이 데이터를 활용하여 다양한 판매 프로모션을 기획하거나, 매출 시뮬레이션을 해볼 수 있습니다! 😊

'sbs 아카데미 학원 수업 > AI 프롬프트 (SBS 아카데미 학원)' 카테고리의 다른 글

| ai 프롬프트 8일차 (2) | 2024.12.05 |

|---|---|

| ai 프롬프트 수업 7일차 (4) | 2024.12.02 |

| AI 프롬프트 수업 6일차 메모내용 (1) | 2024.11.27 |

| AI 프롬프트 수업 4일차 메모내용 (0) | 2024.11.20 |

| AI 프롬프트 수업 3일차 메모내용 (26) | 2024.11.18 |